آیندهای که فیزیک و زبان یکی میشوند

مقدمه: از منطق کلاسیک تا فهم کوانتومی زبان

جهان هوش مصنوعی در دههی اخیر وارد مرحلهای شگفتانگیز شده است. مدلهایی مانند GPT، PaLM و LLaMA با میلیونها پارامتر توانستهاند متن تولید کنند، به پرسشها پاسخ دهند و حتی شعر بسرایند. اما در عمق این فناوری هنوز یک مسئله بنیادی وجود دارد: ماشینها زبان را تولید میکنند، اما آیا واقعاً آن را میفهمند؟

در پس پردهی این پیشرفت، اغلب سیستمها بر پایهی آمار و احتمالات بنا شدهاند. آنها میآموزند که کدام واژه پس از دیگری میآید، اما از منطق درونی جمله و پیوند مفهومی میان اجزاء آگاه نیستند. اینجاست که فیزیک کوانتومی میتواند انقلابی در درک زبان بهوجود آورد.

در نگاه نخست، پیوند میان «کوانتوم» و «زبان» عجیب به نظر میرسد. اما حقیقت این است که در هر دو حوزه، مفهوم درهمتنیدگی و ساختار ترکیبی نقش اساسی دارد. همانگونه که ذرات کوانتومی بهصورت همزمان در چند حالت هستند، معنا نیز در ذهن انسان از تعامل چند مفهوم شکل میگیرد. از این تشابه زیبا، شاخهای جدید زاده شده است: پردازش زبان طبیعی کوانتومی (Quantum NLP).

فناوری کوانتومی در خدمت زبان

در رایانههای کلاسیک، دادهها از بیتها تشکیل شدهاند؛ صفر یا یک. اما در جهان کوانتومی، واحد پایه اطلاعات کیوبیت (Qubit) است که میتواند همزمان در چند حالت باشد. این ویژگی باعث میشود رایانههای کوانتومی بتوانند چندین محاسبه را بهطور موازی انجام دهند.

وقتی این مفهوم در مدلهای زبانی به کار گرفته میشود، نتایج شگفتانگیز است. هر واژه بهجای آنکه یک بردار ثابت باشد، به حالت کوانتومی تبدیل میشود و با سایر واژهها بهصورت درهمتنیده ارتباط پیدا میکند. به این ترتیب، جمله نه از جمع سادهی معانی کلمات، بلکه از برهمکنش پویا و چندبعدی آنها ساخته میشود.

از آمار تا ساختار؛ چرا مدلهای کلاسیک کافی نیستند؟

مدلهایی مانند BERT یا GPT از دید زبانی، شبیه آینههایی هستند که الگوهای آماری زبان را بازتاب میدهند. اما این مدلها قادر نیستند روابط منطقی درونی جملات را بهدرستی درک کنند. برای مثال، اگر جملهی «مریم سیب خورد» را ببینند، میدانند که واژهی «سیب» با «میوه» مرتبط است، اما نمیتوانند استدلال کنند که «اگر مریم سیب خورد، پس میوه هم خورد».

در مقابل، مدلهای QNLP از منطق کوانتومی بهره میبرند که بهطور ذاتی ساختاری و ترکیبی است. این مدلها میتوانند روابط معنایی میان اجزای جمله را بهصورت همزمان و چندلایه پردازش کنند، درست مانند ذهن انسان.

چگونه زبان در مدارهای کوانتومی بازنمایی میشود؟

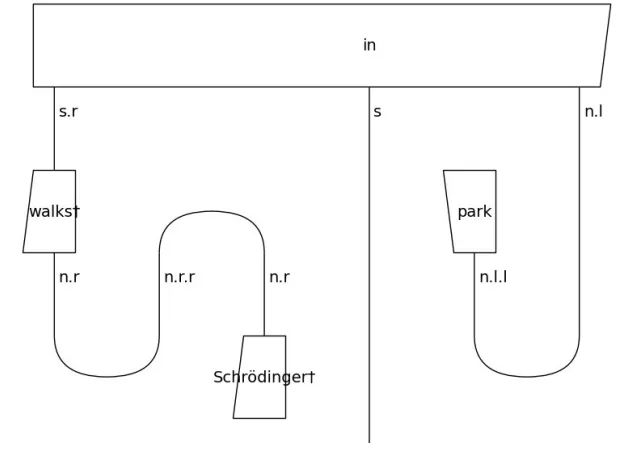

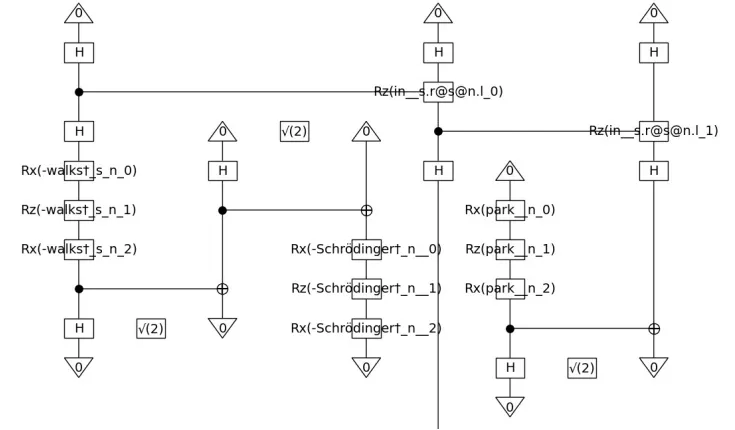

QNLP از چارچوبی به نام DisCoCat استفاده میکند؛ مدلی که از ریاضیات «نظریه ردهها» الهام گرفته است. در این مدل، هر واژه نوع خاصی دارد: اسمها بهصورت حالتهای کوانتومی و افعال بهصورت عملیات یا دروازههای کوانتومی نمایش داده میشوند.

در این مدار، واژهی «شرودینگر» یک کیوبیت ورودی است، «راه میرود» بهصورت دروازهای که حالت او را تغییر میدهد مدلسازی میشود، و «در پارک» بهصورت پیوند میان دو حالت تعریف میگردد. نتیجهی نهایی، یک حالت کوانتومی است که معنای جمله را بهصورت فشرده و درهمتنیده در خود دارد.

استنتاج زبانی؛ آزمونی برای درک واقعی معنا

یکی از چالشهای اساسی در پردازش زبان، استنتاج زبانی (NLI) است. در این وظیفه، مدل باید تشخیص دهد آیا یک جمله از جملهی دیگر نتیجه میشود یا نه.

مثلاً:

• «مریم سیب خورد» → «مریم میوه خورد» (رابطهی دلالت)

• «سگ پارس میکند» ↔ «سگ ساکت است» (رابطهی تناقض)

در مدلهای کوانتومی، این نوع استنتاج از طریق مقایسهی حالتهای کوانتومی جملات انجام میشود. میزان همپوشانی یا فاصله میان این حالتها، میزان دلالت یا تناقض را نشان میدهد. این فرآیند در مدلهای QNLP با دقت بالایی شبیهسازی شده است.

معرفی سه مدل اصلی QNLP

۱. مدل Q-KL: سنجش شباهت معنایی با واگرایی کوانتومی

در این مدل، هر جمله بهصورت یک حالت کوانتومی (ρ) بازنمایی میشود. سپس با استفاده از واگرایی کولبک–لیبلر (KL Divergence) شباهت میان جملات سنجیده میشود. اگر جملهی A بیشتر دربرگیرندهی حالت جملهی B باشد، نتیجه میشود که A جملهی B را «دلالت» میکند.

| مدل | تعداد پارامترهای قابل آموزش | خطای میانگین مربعی (MSE) | امتیاز F1 در استنتاج زبانی |

|---|---|---|---|

| SBERT پیشتمرینشده | حدود ۱۰۰ میلیون | ۰٫۰۱۴ | ۰٫۶۹۰ |

| SBERT تصادفی | حدود ۱۰۰ میلیون | ۰٫۰۱۷ | ۰٫۲۳۲ |

| Q-KL (کوانتومی) | ۹۸۱ | ۰٫۰۳۸ | ۰٫۲۳۲ |

| Q-XOR (هیبریدی) | ۱۰۴۲ | ۰٫۰۰۹ | ۰٫۲۳۲ |

| Q-Cluster (خوشهای) | ۷۹۹ | ۰٫۰۱۲ | ۰٫۴۶۷ |

نتیجه روشن است: مدل Q-Cluster با وجود کوچکی، در استنتاج زبانی عملکردی نزدیک به مدلهای کلاسیک دارد و در برخی معیارها از آنها پیشی گرفته است.

۲. مدل Q-XOR: همافزایی کلاسیک و کوانتومی

در این معماری، مدار کوانتومی ساختار معنایی جمله را استخراج میکند و سپس خروجی آن وارد شبکهای کلاسیک بهنام XORNet میشود.

این ترکیب باعث میشود مدل هم از دقت ساختاری کوانتوم و هم از انعطاف شبکههای کلاسیک بهره ببرد. نتایج نشان داد این مدل در سنجش «شباهت معنایی» عملکردی بهتر از حتی SBERT دارد (کمترین خطای MSE بین همه مدلها).

۳. مدل Q-Cluster: یادگیری اشتراکی میان مدارها

در مدلهای ابتدایی، هر جمله مدار مستقل خود را داشت و پارامترها میان آنها به اشتراک گذاشته نمیشد. این موضوع مانع یادگیری تعمیمپذیر بود. مدل Q-Cluster با ابداع سازوکاری برای خوشهبندی معنایی واژهها، توانست این مشکل را حل کند.

در این مدل، واژههای مشابه در یک خوشه قرار میگیرند و پارامترهای مدار از میانگین این خوشهها نمونهبرداری میشوند. این کار منجر به اشتراک اطلاعات میان جملات مختلف و در نهایت بهبود یادگیری شد.

| مدل | بیشینهی شاخص IGPP | نسبت بهرهوری نسبت به مدل کلاسیک |

|---|---|---|

| SBERT تصادفی | ۳×۱۰⁻⁹ | ۱ برابر (پایه مقایسه) |

| Q-KL | ۹×۱۰⁻⁵ | حدود ۳۰٬۰۰۰ برابر |

| Q-XOR | ۱٫۵×۱۰⁻⁴ | حدود ۵۰٬۰۰۰ برابر |

| Q-Cluster | ۸×۱۰⁻⁵ | حدود ۲۶٬۰۰۰ برابر |

| شاخص | Q-Cluster | بهترین مقدار در سایر مدلها | مدل مرجع |

|---|---|---|---|

| خطای میانگین مربعی (MSE) | ۰٫۰۱۲ | ۰٫۰۰۹ | Q-XOR |

| دقت استنتاج (F1) | ۰٫۴۶۷ | ۰٫۲۳۲ | Q-KL |

| شاخص IGPP | ۸×۱۰⁻⁵ | ۱٫۵×۱۰⁻⁴ | Q-XOR |

| معیار بیز (BIC) | ۳٫۹×۱۰³ | ۴٫۷×۱۰³ | Q-KL |

نتیجهگیری فنی: کوچک اما قدرتمند

با وجود آنکه مدلهای کوانتومی تنها چندصد پارامتر دارند، توانستهاند در سطح عملکردی نزدیک به مدلهایی با میلیونها پارامتر ظاهر شوند. رمز این موفقیت در ویژگیهای بنیادی فیزیک کوانتوم است:

• درهمتنیدگی: انتقال معنا میان اجزای جمله بهصورت همزمان.

• برهمنهی: امکان نمایش چند مفهوم در یک حالت.

• تداخل کوانتومی: ترکیب طبیعی معانی در جمله.

این ویژگیها به مدل اجازه میدهند ساختار معنایی جمله را همانند ذهن انسان بهصورت کلنگر درک کند.

یادگیری خوشهای؛ پلی میان ذهن و ماشین

یکی از جذابترین بخشهای مدل Q-Cluster، مفهوم یادگیری جمعی میان واژههاست. بهجای آموزش جداگانهی هر کلمه، مدل خوشههایی از کلمات مشابه میسازد و پارامترها را میان آنها به اشتراک میگذارد. این فرایند شبیه به عملکرد مغز در تعمیم مفاهیم است.

برای مثال، واژههای «پسر»، «کودک»، «نوجوان» در یک خوشه قرار میگیرند و هر جملهای که شامل این واژهها باشد، از همان پارامترهای مشترک بهره میبرد. این همان چیزی است که به مدل قدرت استنتاج مفهومی میدهد.

چرا QNLP میتواند آیندهی زبان در هوش مصنوعی باشد؟

فناوری QNLP صرفاً یک مدل جدید نیست؛ بلکه آغازگر پارادایمی تازه در درک زبان است. این فناوری نشان میدهد که میتوان با منابع اندک و بدون نیاز به میلیاردها پارامتر، به درکی ساختاری و مفهومی از زبان دست یافت.

از سوی دیگر، مدلهای کوانتومی از لحاظ مصرف انرژی بسیار بهینهترند، زیرا مدارهای کوانتومی بهجای محاسبات سنگین آماری، از خواص طبیعی فیزیک برای ترکیب و تفسیر دادهها بهره میبرند. این موضوع میتواند مسیر هوش مصنوعی سبز را هموار کند.

ابعاد فلسفی: آیا ذهن انسان هم کوانتومی است؟

برخی اندیشمندان مانند «راجر پنروز» معتقدند ذهن انسان ممکن است از سازوکارهای کوانتومی برای پردازش معنا استفاده کند. اگر چنین باشد، مدلهای QNLP نه فقط ابزار محاسباتی، بلکه بازتابی از نحوهی تفکر انساناند.

در این دیدگاه، هر جمله حاصل تعامل درونی میان حالتهای ذهنی درهمتنیده است، درست همانگونه که در مدارهای کوانتومی معنا از تعامل کیوبیتها پدید میآید. شاید بتوان گفت: QNLP آینهای از تفکر انسان در مقیاس فیزیکی است.

کاربردهای آینده QNLP

• ترجمهی چندزبانهی معنایی: درک مفاهیم بدون وابستگی به واژهها.

• تحلیل احساسات و طعنه: تشخیص لایههای ضمنی در گفتار انسانی.

• چتباتهای فلسفی و آموزشی: گفتوگوهایی که فراتر از پاسخ، معنا را درک میکنند.

• تحلیل متون دینی و ادبی: بررسی استعارهها با مدلهای درهمتنیدهی معنا.

• طراحی سامانههای کممصرف انرژی: با بهرهگیری از IGPP بالا و پارامترهای اندک.

چالشهای مسیر پیشرو

در حال حاضر، بزرگترین مانع پیشرفت QNLP، محدودیت سختافزارهای کوانتومی است. شبیهسازی مدارهای زبانی برای جملات طولانی هنوز پرهزینه است. همچنین، ایجاد مجموعهدادههای بزرگ با برچسبهای دقیق معنایی در زبانهای مختلف نیازمند همکاری بینالمللی است.

بااینحال، روند رشد در این زمینه بسیار سریع است و احتمالاً در دههی آینده، با ظهور پردازندههای کوانتومی تجاری، این موانع برطرف خواهند شد.

جمعبندی: همگرایی فیزیک و زبان

QNLP نشان داده است که زبان انسانی، چیزی بیش از توالی کلمات است؛ زبان شبکهای از حالتهای درهمتنیده است که معنا را در سطحی کوانتومی بازنمایی میکند.

وقتی هوش مصنوعی بتواند این ساختار را تقلید کند، دیگر تنها جملهساز نخواهد بود، بلکه درککنندهی معنا میشود.

در آیندهای نهچندان دور، ممکن است دستیارهای هوشمندی داشته باشیم که نهفقط پاسخ میدهند، بلکه مفهوم پرسش ما را میفهمند. در آن زمان، مرز میان زبان و فیزیک از میان برداشته میشود و هوش مصنوعی، گامی دیگر به سوی آگاهی برمیدارد.