پرامپت سبز: انقلابی در کاهش مصرف انرژی مدلهای زبانی بزرگ

مقدمه: چالش زیستمحیطی هوش مصنوعی

در دنیای امروز، هوش مصنوعی (AI) و بهویژه مدلهای زبانی بزرگ (LLMs) نقشی کلیدی در حوزههای مختلف از موتورهای جستجو تا تولید کد و خلق متن ایفا میکنند. مدلهایی نظیر GPT، Mistral، Vicuna و Gemma ابزارهای قدرتمندی هستند که در تولید محتوا، پاسخگویی به سؤالات، تحلیل احساسات، ترجمه، خلاصهسازی و صدها کاربرد دیگر مورد استفاده قرار میگیرند. اما یکی از چالشهای اصلی این فناوری، مصرف انرژی بالا در فرآیند استنتاج (Inference) است که هم بر پایداری محیطزیست و هم بر هزینههای مالی تأثیر میگذارد.

در این مقاله، با مفهوم پرامپت سبز (Green Prompting) آشنا میشویم؛ رویکردی نوین که با بهینهسازی طراحی پرامپتها، مصرف انرژی مدلهای زبانی را کاهش میدهد. پرامپت سبز یعنی طراحی هوشمندانه و هدفمند دستوراتی که به مدل داده میشود تا علاوه بر دقت بالا، مصرف انرژی را نیز به حداقل برساند. این مقاله بر اساس مطالعهای جامع از دانشگاه لنکستر، به بررسی عوامل مؤثر بر مصرف انرژی در استنتاج LLMs و راهکارهای عملی برای کاهش آن میپردازد.

پرامپت سبز چیست و چرا اهمیت دارد؟

پرامپت سبز به معنای طراحی پرامپتهایی است که با کمترین مصرف انرژی، بهترین خروجی را از مدلهای زبانی بزرگ تولید کنند. این رویکرد نهتنها به کاهش ردپای کربن کمک میکند، بلکه هزینههای عملیاتی را نیز بهینه میسازد. با توجه به اینکه استنتاج تا 65% از ردپای کربن یک مدل هوش مصنوعی را تشکیل میدهد، بهینهسازی پرامپتها میتواند تأثیر چشمگیری بر پایداری فناوری داشته باشد.

چرا مصرف انرژی در هوش مصنوعی مهم است؟

برخلاف باور عمومی، هزینهی اصلی اجرای مدلهای زبانی مربوط به آموزش اولیه (training) نیست. بلکه بیش از ۶۵ درصد انرژی مصرفی یک مدل زبانی در مرحلهی استنتاج اتفاق میافتد. یعنی هر بار که ما با یک چتبات صحبت میکنیم، متن تولید میکنیم یا ترجمهای میخواهیم، انرژی قابلتوجهی مصرف میشود.

مدلهای زبانی بزرگ، مانند BLOOM با 176 میلیارد پارامتر، در فرآیند آموزش و استنتاج انرژی قابلتوجهی مصرف میکنند. برای مثال، آموزش BLOOM حدود 433,196 کیلوواتساعت انرژی مصرف کرده و هر استنتاج آن بهطور متوسط 3.96 واتساعت نیاز دارد. با توجه به میلیاردها استنتاج روزانه در جهان، این ارقام نشاندهنده تأثیر عظیم هوش مصنوعی بر محیطزیست است.

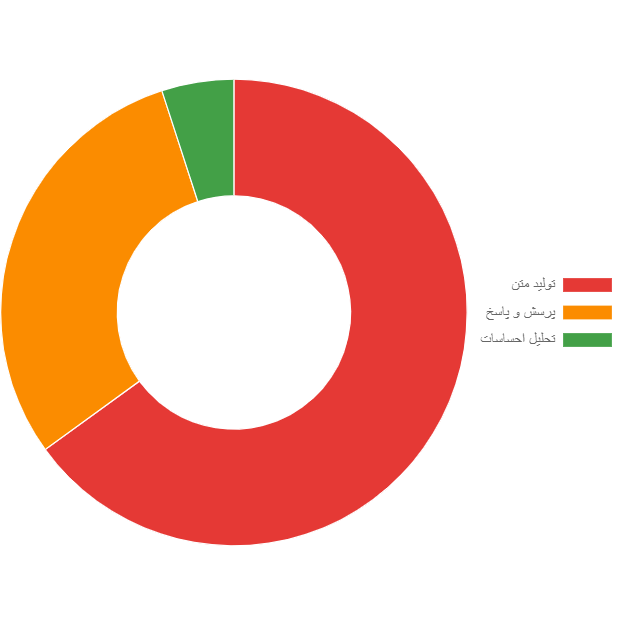

توزیع مصرف انرژی بر اساس نوع وظیفه

نمودار تحقیقات نشان میدهد که وظایف تولید متن بیشترین مصرف انرژی (حدود 65%) را دارند، در حالی که تحلیل احساسات کمترین مصرف را دارد. پرسش و پاسخ در حد متوسط قرار میگیرد.

معرفی مطالعه علمی – چگونه پرامپتها بر مصرف انرژی اثر میگذارند؟

مطالعهای که توسط محققان دانشگاه لنکستر انجام شده، نشان میدهد که ویژگیهای پرامپت مانند طول پرامپت، معنای معنایی (Semantic Meaning) و کلمات کلیدی تأثیر مستقیمی بر مصرف انرژی دارند. این پژوهش با آزمایش سه مدل زبانی منبعباز (Mistral 7B، Gemma 7B و Vicuna 7B) در سه نوع وظیفه (پاسخ به سؤال، تحلیل احساسات و تولید متن) به نتایج جالبی دست یافته است.

در این پژوهش، ۹۰۰۰ پرامپت در سه دسته اصلی مورد بررسی قرار گرفت:

- پاسخگویی به سؤالات (Q&A)

- تحلیل احساسات (Sentiment Analysis)

- تولید متن (Text Generation)

چارچوب آزمایشی: چگونه مصرف انرژی را اندازهگیری کردند؟

محققان یک چارچوب آزمایشی طراحی کردند که امکان اندازهگیری دقیق مصرف انرژی در استنتاج را فراهم میکرد. این چارچوب شامل موارد زیر بود:

- مدلها: سه مدل 7 میلیارد پارامتری (Mistral 7B، Gemma 7B، Vicuna 7B) انتخاب شدند تا تعادل بین عملکرد و محدودیتهای منابع حفظ شود.

- وظایف: 9000 پرامپت در سه دسته (پاسخ به سؤال، تحلیل احساسات، تولید متن) از پایگاههای داده متنوع مانند SQuAD، IMDB و OpenOrca استفاده شد.

- هیپرپارامترها:

- دما (Temperature): [0.3, 0.5, 0.7] برای کنترل تنوع پاسخها.

- حداکثر زمان (Max Time): [4 ثانیه، 10 ثانیه، بدون محدودیت].

- حداکثر توکنهای جدید (Max New Tokens): [10, 50, 100].

- حافظه کم (Low Memory): [True, False] برای کاهش مصرف حافظه.

- اندازهگیری انرژی: با استفاده از کتابخانه ZEUS و NVML، مصرف انرژی GPU (NVIDIA A100) بهطور دقیق ثبت شد.

- محیط آزمایش: یک خوشه محلی با سیستمعامل Ubuntu 20.04.6، پردازنده Intel Xeon Gold 6336Y، و یک GPU NVIDIA A100.

این چارچوب با اجرای 891,000 آزمایش منحصربهفرد (99 تنظیم مدل × 9000 پرامپت)، دادههای جامعی برای تحلیل فراهم کرد.

عوامل کلیدی در مصرف انرژی مدلهای زبانی

محققان در این مطالعه عوامل متعددی را که بر مصرف انرژی استنتاج تأثیر میگذارند، بررسی کردند:

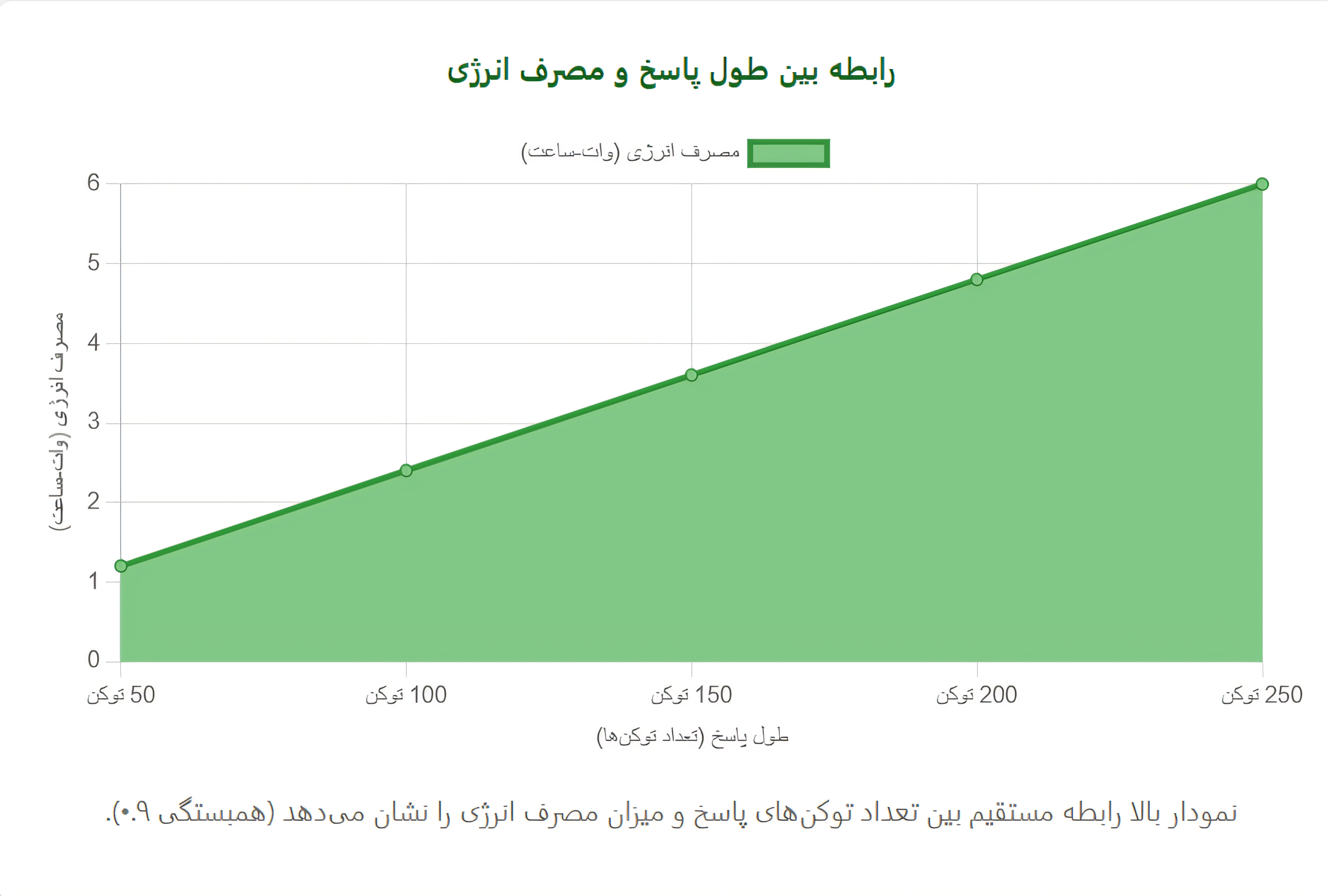

1. طول پاسخ (Response Length)

یکی از مهمترین یافتهها این بود که طول پاسخ تولیدشده توسط مدل، تأثیر مستقیمی بر مصرف انرژی دارد. تحلیلها نشان داد که بین طول پاسخ و مصرف انرژی همبستگی قوی (ضریب همبستگی پیرسون 0.9) وجود دارد. این به این معناست که پاسخهای طولانیتر، به دلیل محاسبات بیشتر برای پیشبینی توکنهای بعدی، انرژی بیشتری مصرف میکنند. هر توکن (واحد زبانی در مدلهای زبانی) هزینهای محاسباتی دارد؛ هرچه پاسخ طولانیتر باشد، محاسبات بیشتری انجام میشود و در نتیجه انرژی بیشتری مصرف میشود.

2. طول پرامپت (Prompt Length)

برخلاف تصور رایج، طول پرامپت تأثیر کمتری نسبت به طول پاسخ بر مصرف انرژی دارد. با این حال، معنای معنایی پرامپت نقش مهمتری ایفا میکند. برای مثال، پرامپتهایی که از مدل میخواهند توضیحات مفصل ارائه دهد، معمولاً پاسخهای طولانیتری تولید میکنند و در نتیجه انرژی بیشتری مصرف میشود.

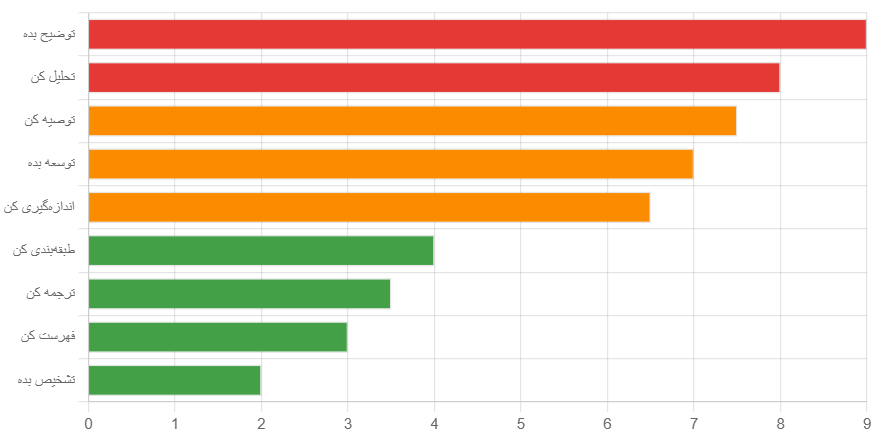

3. معنای معنایی و کلمات کلیدی

معنای معنایی پرامپت (Semantic Meaning) تأثیر بسیار بیشتری نسبت به تعداد توکنها دارد. یعنی یک جمله کوتاه مثل «توضیح بده چرا…» میتواند پاسخ بلندی تولید کند و انرژی بیشتری مصرف کند، در حالیکه یک پرامپت طولانی ولی دقیق ممکن است پاسخ مختصری ایجاد کند.

پژوهشگران با بررسی ۵۰ واژهی رایج در پرامپتها دریافتند که برخی کلمات خاص باعث افزایش مصرف انرژی میشوند:

🔺 پرمصرفترین کلمات:

- «توضیح بده» (explain)

- «تحلیل کن» (analyse)

- «توصیه کن» (recommend)

- «توسعه بده» (develop)

- «اندازهگیری کن» (measure)

- «طبقهبندی کن» (classify)

- «ترجمه کن» (translate)

- «فهرست کن» (list)

- «تشخیص بده» (identify)

کلمات خاص مانند “تحلیل” (Analyse) و “توضیح” (Explain) در وظایف پاسخ به سؤال و تولید متن، با پاسخهای طولانیتر و مصرف انرژی بالاتر مرتبط بودند. در مقابل، کلمه “طبقهبندی” (Classify) در تحلیل احساسات، معمولاً پاسخهای کوتاهتری تولید میکرد و انرژی کمتری مصرف میشد.

4. نوع وظیفه (Task Type)

وظایف مختلف تأثیر متفاوتی بر مصرف انرژی دارند:

- تحلیل احساسات: کمترین مصرف انرژی (زیر 500 ژول) به دلیل پاسخهای کوتاه و مشخص.

- پاسخ به سؤال و تولید متن: انرژی بیشتری (حدود 500 ژول به بالا) به دلیل نیاز به پاسخهای مفصل و پیچیده.

5. مدلهای مختلف

هر مدل زبانی به دلیل تفاوت در معماری و دادههای آموزشی، مصرف انرژی متفاوتی دارد:

- Mistral 7B: کمترین مصرف انرژی (547 ژول بهطور متوسط).

- Gemma 7B: بیشترین مصرف انرژی (727 ژول) به دلیل پاسخهای طولانیتر.

- Vicuna 7B: مصرف انرژی متوسط (700 ژول) اما با پاسخهایی که اغلب شامل ایموجی بودند.

6. ایموجیها

جالب است که مدل Vicuna 7B تمایل به استفاده از ایموجیها در پاسخها داشت. اگرچه ایموجیها بهخودیخود تأثیر مستقیمی بر مصرف انرژی نداشتند، اما پاسخهای حاوی ایموجی معمولاً طولانیتر بودند و در نتیجه انرژی بیشتری مصرف میکردند.

نتایج کلیدی و راهکارهای عملی برای نوشتن پرامپت سبز

یافتههای اصلی:

- طول پاسخ مهمترین عامل در مصرف انرژی است.

- معنای معنایی پرامپت و کلمات کلیدی خاص (مانند “توضیح” و “تحلیل”) میتوانند پاسخهای طولانیتر و در نتیجه مصرف انرژی بیشتری ایجاد کنند.

- تحلیل احساسات کمترین انرژی را مصرف میکند، در حالی که پاسخ به سؤال و تولید متن انرژی بیشتری نیاز دارند.

- تفاوت در معماری مدلها و دادههای آموزشی (مانند اندازه واژگان یا نوع دادههای آموزشی) بر طول پاسخ و مصرف انرژی تأثیر میگذارد.

بر اساس نتایج پژوهش، میتوان مجموعهای از راهنماییهای کاربردی برای کاهش مصرف انرژی مدلهای زبانی ارائه کرد:

✅ ۱. از کلمات پرمصرف اجتناب کنید

بهجای واژگان عمومی مثل “توضیح بده”، از پرسشهای دقیق و هدفمند استفاده کنید که خروجی مدل محدود باشد.

✅ ۲. هدف خود را بهوضوح و با محدودیت مشخص کنید

مثلاً بهجای «درباره تأثیر اینترنت بنویس»، بپرسید: «در دو جمله، تأثیر منفی اینترنت بر خواب نوجوانان را بیان کن.»

✅ ۳. از تنظیمات محدودکننده استفاده کنید

در صورت امکان، از پارامترهایی مثل:

- max_new_tokens

- max_time

- temperature

برای کنترل خروجی مدل استفاده کنید.

✅ ۴. از فرمتهای ساختاریافته بهره ببرید

در وظایفی مثل تحلیل احساسات، خروجی را به صورت JSON یا بولی (مثبت/منفی) محدود کنید.

✅ ۵. کوتاه کردن پاسخها

پرامپتهایی طراحی کنید که پاسخهای کوتاه و دقیق تولید کنند. برای مثال، به جای “توضیح دهید”، از “بهصورت خلاصه بیان کنید” استفاده کنید.

✅ ۶. انتخاب مدل مناسب

مدلهایی مانند Mistral 7B که انرژی کمتری مصرف میکنند، برای کاربردهای حساس به انرژی مناسبترند.

آیندهای پایدار با مهندسی پرامپت سبز

مطالعه دانشگاه لنکستر نشان داد که پرامپت سبز میتواند راهکاری مؤثر برای کاهش مصرف انرژی در مدلهای زبانی بزرگ باشد. با تمرکز بر طول پاسخ، معنای معنایی پرامپت، و کلمات کلیدی، میتوان استنتاج را بهینه کرد و به سمت هوش مصنوعی پایدارتر حرکت کرد.

با افزایش تقاضا برای کاربردهای هوش مصنوعی، نیاز به راهکارهای پایدار بیش از پیش احساس میشود. پرامپت سبز نهتنها به کاهش مصرف انرژی کمک میکند، بلکه میتواند هزینههای عملیاتی را کاهش داده و دسترسی به فناوری را برای شرکتهای کوچکتر تسهیل کند. این مطالعه نشان داد که با طراحی هوشمندانه پرامپتها، میتوان بدون افت کیفیت خروجی، مصرف انرژی را بهینه کرد.

همانطور که شاهد بودیم، مهندسی پرامپت سبز نهتنها عملکرد مدلهای زبانی را حفظ میکند بلکه بهطور مستقیم به کاهش ردپای کربنی این فناوریها کمک میکند. در دنیایی که هوش مصنوعی روزبهروز در حال گسترش است، توجه به پایداری و مصرف انرژی باید در مرکز طراحی و توسعه قرار گیرد.

اگر قرار است هوش مصنوعی آیندهای اخلاقمدار، سبز و پایدار داشته باشد، ما باید از هماکنون به طراحی هوشمندانه پرامپتها توجه کنیم. این پژوهش دریچهای برای مطالعات آینده باز کرده تا با بررسی دقیقتر کلمات کلیدی و بهینهسازیهای پیشرفتهتر، فناوری سبزتری خلق شود.

یک پاسخ

سلام و وقت بخیر

ممنونم از شما، مقاله مفیدی بود