آیا مدلهای پیشرفته واقعاً استدلال میکنند یا فقط وانمود میکنند؟

(تحلیل جامع بنچمارک ConceptARC و مدلهای o3, Claude, Gemini)

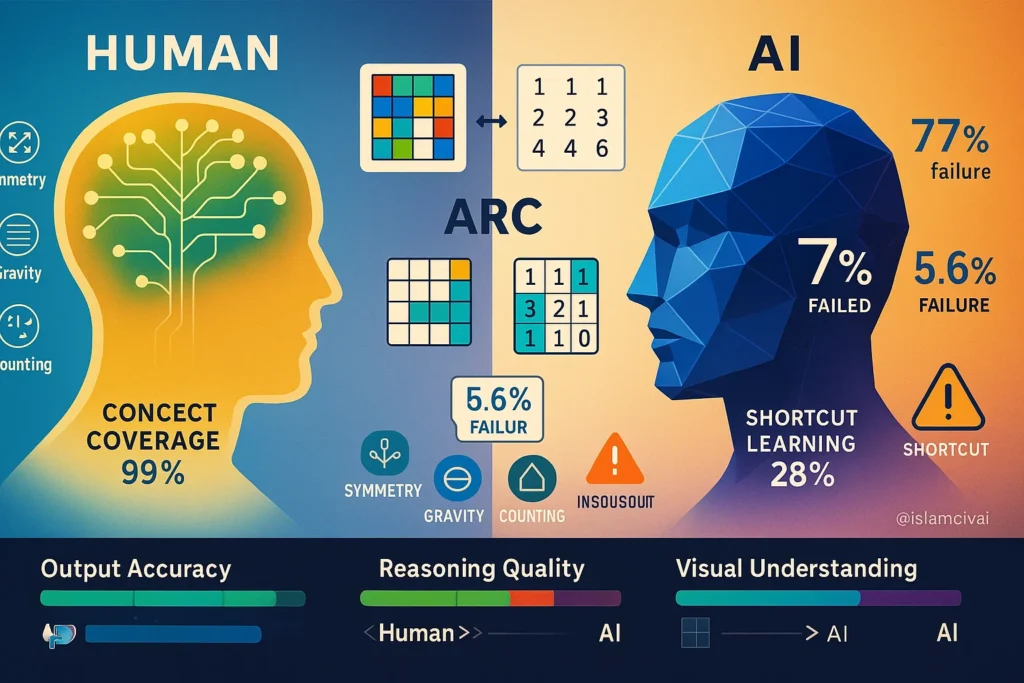

دنیای تکنولوژی در ماههای اخیر با معرفی مدلهای استدلالگر (Reasoning Models) نظیر OpenAI o3، Claude Sonnet و Gemini دچار تحولی شگرف شده است. ادعای بزرگ این مدلها، عبور از مرزهای انسانی در بنچمارکهای دشواری همچون ARC-AGI است. اما سوالی که ذهن پژوهشگران ارشد موسسه سانتافه (Santa Fe Institute) را به خود مشغول کرده، این است: آیا کسب نمره بالا به معنای فهمیدن است؟

در این مقاله تحلیلی و مفصل، ما به بررسی عمیق پژوهش اخیر با عنوان “Do AI Models Perform Human-Like Abstract Reasoning Across Modalities?” میپردازیم. ما با استفاده از دادهها، جداول و نمودارهای دقیق این پژوهش، نشان خواهیم داد که شکاف میان “دقت خروجی” و “فهم انتزاعی” کجاست و چرا هوش مصنوعی هنوز در بینایی، کور است.

۱. مقدمه: توهم هوشمندی در عصر مدلهای چندوجهی

هوش مصنوعی مولد (Generative AI) به نقطهای رسیده است که میتواند شعر بگوید، کد بنویسد و حتی مسائل ریاضی را حل کند. اما “استدلال انتزاعی” (Abstract Reasoning)—یعنی توانایی کشف یک الگوی ناشناخته از روی چند مثال ساده و تعمیم آن به شرایط جدید—همچنان جام مقدس هوش مصنوعی عمومی (AGI) باقی مانده است.

فرانسوا شوله (François Chollet) با طراحی بنچمارک ARC تلاش کرد تا هوش را فراتر از “حفظیات” بسنجد. اما آیا مدلهای جدید واقعاً این تستها را حل میکنند یا راههایی برای دور زدن آنها پیدا کردهاند؟ این مقاله با بررسی مدلها در دو دنیای متفاوت “متن” و “تصویر”، پرده از حقایق تلخی برمیدارد و نشان میدهد که چرا نباید فریب نمرات بالای بنچمارکها را خورد.

۲. بنچمارک ARC و ConceptARC: میدان نبرد استدلال

برای درک عمق این پژوهش، ابتدا باید بدانیم زمین بازی کجاست. اکثر بنچمارکهای هوش مصنوعی بر روی دانش زبانی تمرکز دارند، اما «مجموعه استدلال و انتزاع» (ARC) که توسط فرانسوا شوله طراحی شده، متفاوت است.

تفاوت ARC با تستهای معمولی

تست ARC شامل پازلهای بصری است که نیاز به دانش قبلی خاصی ندارد، بلکه بر «دانش هستهای» (Core Knowledge) مانند درک اشیاء، جاذبه، تقارن و شمارش استوار است. هوش مصنوعی باید با دیدن چند مثال محدود (Few-shot)، قانون پنهان پشت تغییرات را کشف کند و آن را روی یک تست جدید اعمال نماید.

معرفی ConceptARC: سنجش دقیق مفاهیم

پژوهشگران در این مطالعه از نسخه خاصی به نام ConceptARC استفاده کردهاند. بر خلاف ARC اصلی که ممکن است بسیار پیچیده باشد، ConceptARC شامل ۴۸۰ وظیفه (Task) است که حول ۱۶ مفهوم پایه دستهبندی شدهاند (مانند “بالا در مقابل پایین”، “داخل در مقابل خارج”، “پر کردن”). این طراحی اجازه میدهد تا دقیقاً مشخص شود مدل در کدام مفاهیم انتزاعی ضعف دارد.

شکل ۱: نمونههایی از وظایف بنچمارک ConceptARC. ردیف بالا مفهوم “بالا در مقابل پایین” و ردیف پایین مفهوم “استخراج شیء” را نشان میدهد. مدل باید قانون تغییر را کشف کرده و روی شبکه سمت راست اعمال کند.

همانطور که در شکل ۱ میبینید، این مسائل برای انسان بسیار ساده هستند و نیاز به دانش زبانی ندارند، اما برای ماشین چالشبرانگیزاند. هدف این است که ببینیم آیا ماشین “مفهوم” (Concept) را درک میکند یا خیر.

۳. نبرد مدالیتهها؛ پارادوکس متن در برابر تصویر

یکی از بزرگترین و تکاندهندهترین دستاوردهای این پژوهش،عبور از معیارهای سطحی است. تا پیش از این، معیار موفقیت صرفاً “دقت خروجی” (Output Accuracy) بود؛ یعنی آیا تصویر نهایی درست است یا خیر. اما این پژوهشگران دو سوال حیاتی دیگر نیز پرسیدند:

- مدالیته ورودی: آیا مدل وقتی معما را به صورت “متن” (ماتریس اعداد) میبیند بهتر عمل میکند یا وقتی آن را به صورت “تصویر” (Visual) میبیند؟

- تحلیل قوانین (Rule Analysis): آیا توضیحی که مدل برای حل مسئله میدهد، منطقی و انتزاعی است (مانند انسان) یا بر اساس الگوهای سطحی و اشتباه است؟

مقایسه عملکرد مدلها در دو حالت ورودی متفاوت است:

- 📄 حالت متنی (Textual): شبکه شطرنجی به صورت ماتریسی از اعداد به مدل داده میشود.

- 🖼️ حالت تصویری (Visual): شبکه شطرنجی دقیقاً به صورت یک فایل تصویری (مانند دید انسان) به مدل داده میشود.

-

ابزارها و مدلهای مورد بررسیدر این پژوهش، مدلهای استدلالگر (Reasoning Models) زیر مورد آزمایش قرار گرفتند:

- OpenAI o3 (در تنظیمات تلاش کم و متوسط)

- OpenAI o4-mini

- Google Gemini 2.5 Pro

- Anthropic Claude Sonnet 4

همچنین تأثیر استفاده از ابزارهای پایتون (Python Tools) نیز در حل مسائل سنجیده شد.

انتظار میرود یک هوش مصنوعی “چندوجهی” (Multimodal) بتواند در هر دو حالت عملکردی مشابه داشته باشد. اما نتایج خیرهکننده بود و نشان داد که هوش مصنوعی وقتی دنیا را به صورت عدد میبیند نابغه است، اما وقتی همان دنیا را به صورت تصویر میبیند، تقریباً کور میشود.

۳.۱. جدول سقوط آزاد عملکرد در بینایی ماشین

جدول زیر مقایسهای بیرحمانه از عملکرد مدلهای برتر جهان در این دو حالت است. توجه کنید که چگونه اعداد در ستون “Visual” افت میکنند.

| مدل استدلالگر | تلاش کم (متنی / تصویری) | تلاش متوسط (متنی / تصویری) | تلاش کم + ابزار (متنی / تصویری) | تلاش متوسط + ابزار (متنی / تصویری) |

| o3 | ۶۸.۳ / ۶.۷ | ۷۷.۱ / ۵.۶ | ۶۷.۹ / ۱۸.۱ | ۷۵.۶ / ۲۹.۲ |

| o4-mini | ۵۲.۱ / ۳.۸ | ۷۰.۸ / ۸.۱ | ۵۷.۳ / ۶.۷ | ۷۷.۷ / ۲۵.۰ |

| Claude Sonnet 4 | N/A | ۶۰.۲ / ۵.۲ | N/A | ۵۵.۰ / ۶.۹ |

| Gemini 2.5 Pro | N/A | ۶۶.۰ / ۴.۲ | N/A | ۶۰.۴ / ۵.۸ |

جدول ۱: مقایسه دقت خروجی (Pass@1) مدلهای استدلالگر در حالات مختلف. اعداد نشان میدهند که مدل o3 در حالت متنی تا ۷۷٪ دقت دارد، اما در حالت تصویری (بدون ابزار) به ۵.۶٪ سقوط میکند.

این جدول نشان میدهد که مدل o3 در حالت متنی (تلاش متوسط) با دقت ۷۷.۱٪ حتی از میانگین انسانها (۷۳٪) در این مجموعه داده بالاتر است. اما همین مدل وقتی تصویر را میبیند، به دقت ۵.۶٪ میرسد! این یعنی مدلهای زبانی بزرگ، هنوز “بینایی انتزاعی” ندارند؛ آنها ریاضیدانان خوبی هستند که اعداد ماتریس را تحلیل میکنند، اما وقتی با پیکسلها روبرو میشوند، تقریباً کور هستند.

۴. آیا مدلهای قدیمیتر شانسی دارند؟ (نسل قدیم vs نسل جدید)

برای اینکه بفهمیم مدلهای استدلالگر جدید (Reasoning Models) چقدر پیشرفت کردهاند و آیا معماریهای جدید واقعاً موثر بودهاند، باید آنها را با مدلهای استاندارد و قدرتمند قبلی مثل GPT-4o و Llama مقایسه کنیم. نتایج نشان میدهد که مدلهای قدیمی بدون قابلیت “زنجیره فکر” (Chain of Thought)، در مواجهه با مسائل انتزاعی کاملاً ناتوان هستند و عملاً هیچ شانسی برای رقابت ندارند.

📊 مقایسه مدلهای غیراستدلالگر (Pass@1)

اعداد برجسته بهترین عملکرد را نشان میدهند.

| مدل غیر استدلالگر | بدون ابزار پایتون (متنی / تصویری) | با ابزار پایتون (متنی / تصویری) |

| GPT-4o | ۱۴.۶ / ۰.۰ | ۸.۳ / ۰.۲ |

| Llama 4 Scout | ۶.۷ / ۰.۰ | N/A |

| Qwen 2.5 VL 72B | ۹.۲ / ۰.۰ | N/A |

جدول ۲: عملکرد مدلهای غیر استدلالگر. همانطور که مشاهده میشود، GPT-4o و مدلهای مشابه تقریباً هیچ شانسی در حل این مسائل ندارند و دقت آنها نزدیک به صفر است.

این جدول اثبات میکند که تکنیکهای جدید “Test-time Compute” (صرف زمان برای فکر کردن حین تست) که در o3 و o4-mini استفاده شده، برای حل مسائل انتزاعی ضروری است، هرچند هنوز کامل نیست.

۵. کالبدشکافی استدلال؛ درستِ غلط یا غلطِ درست؟

رسیدن به جواب صحیح (Grid درست) کافی نیست. ممکن است دانشآموزی در امتحان ریاضی به جواب درست برسد اما از راه حل غلط رفته باشد. پژوهشگران برای اولین بار، علاوه بر خروجی نهایی، “توضیحات متنی” (Rules) مدلها را نیز بررسی کردند تا ببینند آیا مدل واقعاً “میفهمد” یا خیر.

آنها پاسخها را به سه دسته تقسیم کردند:

- Correct-Intended (سبز): جواب درست با استدلال صحیح و انتزاعی (فهم واقعی).

- Correct-Unintended (زرد): جواب درست اما با استدلال غلط (میانبر زدن).

- Incorrect (قرمز): جواب غلط.

۵.۱. نمودار حقیقت: مقایسه انسان و ماشین

شکل ۲: ارزیابی کیفی قوانین تولید شده توسط مدلها و انسان. بخشهای زرد رنگ نشاندهنده مواردی است که مدل “درست حدس زده” اما “مفهوم را نفهمیده” است. تفاوت فاحش بین انسان (ستون راست) و مدل o3 (ستون چپ) در میزان استدلالهای صحیح (سبز) مشهود است.

۵.۲. دادههای دقیق شکاف استدلالی

برای درک دقیقتر نمودار بالا، به دادههای عددی جدول ۳ نگاه کنید که نشان میدهد هوش مصنوعی چقدر مستعد “توهم استدلال” است.

📊 ارزیابی مدلها در خروجی متنی و تصویری

| مدل (وضعیت خروجی) | متنی (درست منطبق / میانبر / غلط) | تصویری (درست منطبق / میانبر / غلط) |

| o3 (شبکه صحیح) | ۵۴.۸٪ / ۱۵.۶٪ / ۵.۲٪ | ۲۰.۲٪ / ۵.۸٪ / ۳.۱٪ |

| o3 (شبکه غلط) | ۲.۳٪ / ۱۲.۷٪ / ۹.۴٪ | ۱۸.۸٪ / ۱۳.۸٪ / ۳۸.۳٪ |

| Claude (شبکه صحیح) | ۴۴.۴٪ / ۴.۴٪ / ۶.۳٪ | ۴.۰٪ / ۰.۴٪ / ۲.۵٪ |

| Claude (شبکه غلط) | ۱۳.۵٪ / ۹.۲٪ / ۲۲.۳٪ | ۹.۸٪ / ۲.۵٪ / ۸۰.۸٪ |

| Gemini (شبکه صحیح) | ۴۲.۵٪ / ۱۰.۶٪ / ۷.۳٪ | ۴.۶٪ / ۰.۲٪ / ۱.۰٪ |

| Gemini (شبکه غلط) | ۱.۷٪ / ۶.۳٪ / ۳۱.۷٪ | ۱۹.۲٪ / ۴.۴٪ / ۷۰.۶٪ |

| انسان (شبکه صحیح) | ۵۳٪ (درست منطبق) / ۳٪ (میانبر) | (دادههای انسانی تجمیعی هستند) |

جدول ۳: درصد دقیق انواع استدلال در مدلها. نکته تکاندهنده این است که حدود ۱۵ تا ۱۷ درصد از پاسخهای صحیح o3 در حالت متنی، بر پایه “قوانین میانبر” (Unintended) است، در حالی که این عدد برای انسان تنها ۳٪ است.

این دادهها نشان میدهند که هوش مصنوعی در بسیاری از موارد، مسئله را “هک” میکند. مثلاً به جای درک مفهوم “مربع”، الگوی تکرار اعداد را پیدا میکند و تصادفاً به جواب میرسد.

۶. پدیده “یادگیری میانبر” (Shortcut Learning) چیست؟

شاید بپرسید “قانون درست اما غیرمنطبق” دقیقاً یعنی چه؟ این پدیده زمانی رخ میدهد که هوش مصنوعی روی ویژگیهای سطحی تمرکز میکند. مثل دانشآموزی که به جای یادگیری زبان، فقط کلمات کلیدی را حفظ میکند. مدل o3 نیز گاهی به جای دیدن “اشیاء”، روی “عدد رنگ پیکسلها” تمرکز میکند و قوانینی میسازد که فقط در همان لحظه کار میکنند اما هیچ منطقی ندارند.

شکل ۴: نمونههایی از استدلالهای سطحی (میانبر). در تصویر بالا، مدل o3 به جای درک موقعیت مکانی اشیاء، قانونی بر اساس وجود پیکسل رنگ آبی (عدد ۸) ساخته است. این قانون برای مثالهای آموزشی کار میکند اما در واقعیت غلط است.

این شکل قلب این پژوهش است. نشان میدهد چرا نمیتوانیم به هوش مصنوعی در کاربردهای حساس اعتماد کنیم: او ممکن است دلیل تصمیمگیریاش کاملاً بیربط به منطق جهان واقعی باشد.

۷. تأثیر ابزارها؛ آیا پایتون میتواند بینایی را نجات دهد؟

یکی از ویژگیهای مدلهای جدید، توانایی نوشتن و اجرای کد پایتون (Code Execution) است. پژوهشگران بررسی کردند که آیا دسترسی به این ابزار کمکی میکند؟ توضیح دهید که مدلهای زبانی ذاتاً در پردازش تصویر ضعف دارند، اما وقتی به آنها اجازه کدنویسی میدهیم، میتوانند این ضعف را دور بزنند. پایتون مثل یک “عینک” عمل میکند که تاری دید مدل را برطرف میکند، اما لزوماً مغز آن را باهوشتر نمیکند.

۷.۱. جهش عملکرد با کدنویسی

شکل ۳: تأثیر تلاش استدلالی (Low/Medium) و ابزار پایتون بر عملکرد مدل o3. به جهش عملکرد در حالت Visual (سمت راست) وقتی ابزار اضافه میشود دقت کنید.

۷.۲. جزئیات عددی تأثیر ابزار

📋 تنظیمات مدل o3 — وضعیت خروجی

| تنظیمات مدل o3 | متنی (منطبق / میانبر / غلط) | تصویری (منطبق / میانبر / غلط) |

| تلاش کم (شبکه صحیح) | ۴۹.۴ / ۱۳.۱ / ۵.۸ | ۵.۳ / ۰.۲ / ۱.۰ |

| تلاش متوسط (شبکه صحیح) | ۵۲.۷ / ۱۷.۳ / ۷.۱ | ۳.۱ / ۰.۶ / ۱.۹ |

| تلاش کم + ابزار (شبکه صحیح) | ۴۵.۸ / ۱۶.۵ / ۵.۶ | ۱۴.۴ / ۲.۱ / ۱.۷ |

| تلاش متوسط + ابزار (شبکه صحیح) | ۵۴.۸ / ۱۵.۶ / ۵.۲ | ۲۰.۲ / ۵.۸ / ۳.۱ |

جدول ۴: دادههای مربوط به شکل ۳. استفاده از ابزار در حالت تصویری، دقت مدل را از ۵.۶٪ به ۲۹.۲٪ میرساند.

تحلیل: در حالت متنی، مدل با “بیشتر فکر کردن” (افزایش توکنهای استدلال) بهتر میشود. اما در حالت تصویری، فکر کردن فایدهای ندارد؛ مدل نیاز به ابزار دارد تا پیکسلها را ترجمه کند.

۸. کدام مفاهیم برای هوش مصنوعی کابوس هستند؟

آیا همه مفاهیم انتزاعی به یک اندازه سخت هستند؟ خیر. هوش مصنوعی یک موجود یکدست نیست؛ در برخی کارها (مثل کپی کردن) عالی است و در برخی دیگر (مثل تشخیص حفرهها یا تکمیل اشکال) ناتوان. پژوهشگران عملکرد مدلها را در ۱۶ دسته مفهومی مختلف ریز کردند و نتایج نشان داد انسانها در تمام این مفاهیم عملکردی یکنواخت دارند، که نشاندهنده یکپارچگی ذهن انسان در مقابل تکه-تکه بودن قابلیتهای هوش مصنوعی است.

۸.۱. عملکرد مدلها در حالت متنی (Textual)

📊 مقایسه مدلها بر اساس مفاهیم (درصد موفقیت)

| مفهوم | Gemini 2.5 Pro | o3 | o4-mini | Claude Sonnet 4 | انسان |

| بالا/پایین | ۶۰ | ۹۰ | ۸۳.۳ | ۶۳.۳ | ۶۹ |

| مرکز | ۷۰ | ۹۳.۳ | ۹۶.۷ | ۸۳.۳ | ۸۴ |

| پاکسازی | ۲۳.۳ | ۴۶.۷ | ۶۰ | ۴۶.۷ | ۸۹ |

| تکمیل شکل | ۵۶.۷ | ۷۰ | ۶۶.۷ | ۵۰ | ۷۱ |

| کپی | ۶۶.۷ | ۷۰ | ۹۰ | ۵۶.۷ | ۷۸ |

| شمارش | ۸۶.۷ | ۸۰ | ۸۰ | ۷۶.۷ | ۶۱ |

| گسترش تا مرز | ۶۰ | ۹۰ | ۸۳.۳ | ۵۰ | ۸۱ |

| استخراج شیء | ۵۶.۷ | ۷۶.۷ | ۸۶.۷ | ۴۳.۳ | ۶۷ |

| پر/خالی | ۷۳.۳ | ۷۶.۷ | ۸۳.۳ | ۶۳.۳ | ۸۲ |

جدول ۵: مقایسه عملکرد مدلها در مفاهیم مختلف (حالت متنی). مدل o3 در مفاهیمی مثل “Center” (مرکز) عالی عمل میکند اما در “CleanUp” (پاکسازی) ضعیف است.

۸.۲. عملکرد مدلها در حالت تصویری (Visual)

📊 مقایسه مدلها بر اساس مفاهیم (درصد)

| مفهوم (Concept) | Gemini 2.5 Pro | o3 | o4-mini | Claude Sonnet 4 | انسان |

| بالا/پایین | ۰ | ۲۰ | ۱۰ | ۰ | ۶۹ |

| مرکز | ۶٫۷ | ۴۳٫۳ | ۲۶٫۷ | ۶٫۷ | ۸۴ |

| پاکسازی | ۱۰ | ۲۳٫۳ | ۲۶٫۷ | ۱۳٫۳ | ۸۹ |

| تکمیل شکل | ۳٫۳ | ۳۰ | ۲۳٫۳ | ۱۶٫۷ | ۷۱ |

| شمارش | ۱۶٫۷ | ۵۳٫۳ | ۵۰ | ۰ | ۶۱ |

| استخراج شیء | ۳٫۳ | ۳۰ | ۳۶٫۷ | ۰ | ۶۷ |

جدول ۶: مقایسه عملکرد در حالت تصویری. در اینجا انسان (ستون آخر) با اختلاف فاحش در تمام مفاهیم پیشتاز است.

تفاوت کلیدی در جدول ۶ نهفته است. انسانها در مفاهیمی مثل “تماس با مرز” (ExtendToBoundary) یا “تشخیص حفره” بسیار قوی هستند، در حالی که هوش مصنوعی در حالت تصویری تقریباً در این موارد صفر است.

۸.۳. شکاف میان “پاکسازی” و “شمارش”

چرا برخی مفاهیم سختترند؟ شکل زیر پاسخ میدهد.

شکل ۵: مقایسه دو مفهوم “شمارش” (Count) و “پاکسازی” (CleanUp). در تسک شمارش که خروجی ساده است، مدلها خوب عمل میکنند. اما در پاکسازی که نیاز به بازتولید یک شبکه پیچیده دارد، مدلها شکست میخورند.

۹. انسان در برابر ماشین؛ مسئله “پوشش” (Coverage)

آیا هوش مصنوعی میتواند “همه” انواع مسائل را حل کند؟ “جامعیت” (Robustness) مهمترین ویژگی هوش واقعی است. انسان ممکن است خسته شود و اشتباه کند، اما تقریباً “همه” مفاهیم را میفهمد. در مقابل، هوش مصنوعی لکههای کوری دارد که باعث میشود در دنیای واقعی غیرقابل اعتماد باشد. جدول زیر نشان میدهد که انسانها چقدر منعطفتر هستند.

📈 پوشش وظایف — دستهبندی و مدالیته

| دستهبندی | مدالیته | تعداد وظایف پوشش داده شده (از ۴۸۰) | درصد پوشش |

| انسانها | کلی | ۴۷۵ | ۹۸.۹۶٪ |

| o3 | متنی | ۴۱۰ | ۸۵.۴۲٪ |

| o3 | تصویری | ۲۸۱ | ۵۸.۵۴٪ |

| Claude | متنی | ۳۴۳ | ۷۱.۴۶٪ |

| Gemini | متنی | ۲۹۳ | ۶۱.۰۴٪ |

| تجمیع مدلها | متنی | ۴۵۱ | ۹۳.۹۶٪ |

| تجمیع مدلها | تصویری | ۳۲۰ | ۶۶.۶۷٪ |

جدول ۷: درصد پوشش وظایف. انسانها توانستهاند برای ۹۸.۹۶٪ از کل مسائل، قانون صحیح را کشف کنند. بهترین تجمیع مدلهای هوش مصنوعی در حالت تصویری تنها ۶۶٪ مسائل را پوشش میدهد.

این جدول میخ آخر بر تابوت ادعای “فرا-انسانی” بودن مدلهای فعلی در استدلال عمومی است. انسانها شاید گاهی بیدقت باشند، اما تقریباً همیشه “میفهمند” چه خبر است.

۱۰. چرا مدلها اشتباه میکنند؟ تحلیل خطاها

وقتی مدل o3 اشتباه میکند، چه نوع اشتباهی مرتکب میشود؟ در این بخش فنیتر، ماهیت اشتباهات مدلها را بررسی میکنیم. دادهها نشان میدهند که مدلها گاهی اشتباهات بسیار ابتدایی میکنند، مثل اینکه یادشان میرود جدول باید مستطیل باشد یا تعداد ستونها را اشتباه میکشند. این نشان میدهد که مدلها هنوز درک فضایی (Spatial Awareness) درستی ندارند.

شکل ۶: دستهبندی خطاهای o3. ستونهای سبز (Uneven row lengths) نشان میدهد که مدل در حالت تصویری حتی نمیتواند یک جدول منظم بکشد و خروجیهای کج و معوج میدهد.

۱۱. آیا سختگیری در فرمتدهی نتایج را تغییر میدهد؟ (ارزیابی مجدد)

منتقدان ممکن است بگویند: “شاید مدل جواب درست را داده اما فرمت خروجیاش استاندارد نبوده است.” پژوهشگران برای اطمینان از نتایج و پاسخ به این نقد، حتی پاسخهای بدخط و ناخوانای مدلها را هم (اگر درست بودند) پذیرفتند و نتایج را بازبینی کردند.

۱۱.۱. دقت بازبینی شده با ارفاق

| مدل (تنظیمات) | متنی (دقت اصلی / بازبینی شده) | تصویری (دقت اصلی / بازبینی شده) |

|---|---|---|

| o3 (تلاش متوسط + ابزار) | ۷۵.۶ / ۷۵.۶ | ۲۹.۲ / ۲۹.۲ |

| o4-mini (تلاش متوسط + ابزار) | ۷۷.۷ / ۷۸.۸ | ۲۵.۰ / ۲۵.۰ |

| Claude (متوسط + ابزار) | ۵۵.۰ / ۵۹.۲ | ۶.۹ / ۶.۹ |

| GPT-4o (با ابزار) | ۸.۳ / ۱۳.۱ | ۰.۲ / ۰.۲ |

جدول ۸: مقایسه دقت اصلی با دقت بازبینیشده (Re-assessed). حتی با پذیرفتن فرمتهای غیرستاندارد، تغییر چشمگیری در نتایج بصری ایجاد نمیشود.

۱۱.۲. نمودار نهایی قوانین اصلاح شده

شکل ۷: ارزیابی مجدد قوانین با در نظر گرفتن پاسخهای درست اما بد-فرمت. الگوی کلی (ضعف شدید در بینایی و وابستگی به میانبرها) همچنان پابرجاست.

این بخش (شکل ۷ و جدول ۸) استحکام علمی پژوهش را تضمین میکند و ثابت میکند که ضعف هوش مصنوعی، ذاتی است و نه ناشی از مشکلات فنی فرمتدهی.

۱۲. نتیجهگیری: آینده هوش مصنوعی و درسهایی برای توسعهدهندگان

این پژوهش گسترده و دادهمحور، یک حقیقت روشن را بیان میکند: هوش مصنوعی هنوز به استدلال انتزاعی شبیه انسان دست نیافته است. ما هنوز تا ساخت ماشینی که بتواند مثل ما “ببیند” و “فکر کند”، فاصله داریم.

- توهم دانایی: مدلها در حالت متنی عالی هستند، اما بخشی از این موفقیت مدیون “میانبرهای آماری” است، نه فهم عمیق.

- کوری بصری: مدلهای چندوجهی (Multimodal) هنوز نمیتوانند مفاهیم انتزاعی را مستقیماً از پیکسلها استخراج کنند. آنها جهان را میبینند، اما آن را درک نمیکنند.

- قدرت ابزار: ادغام کدنویسی (Python) با مدلهای زبانی، راهکاری موقت اما موثر برای جبران ضعفهای استدلالی است.

برای رسیدن به هوش عمومی مصنوعی (AGI)، ما نیاز به مدلهایی داریم که تنها “پیشبینیکننده کلمه بعدی” نباشند، بلکه بتوانند جهان را مدلسازی کنند، مفاهیم را مستقل از مدالیته (متن یا تصویر) یاد بگیرند و بدون نیاز به هزاران مثال، قانونِ پنهانِ هستی را کشف کنند. تا آن زمان، انسان همچنان فرمانروای قلمرو استدلال انتزاعی باقی خواهد ماند.